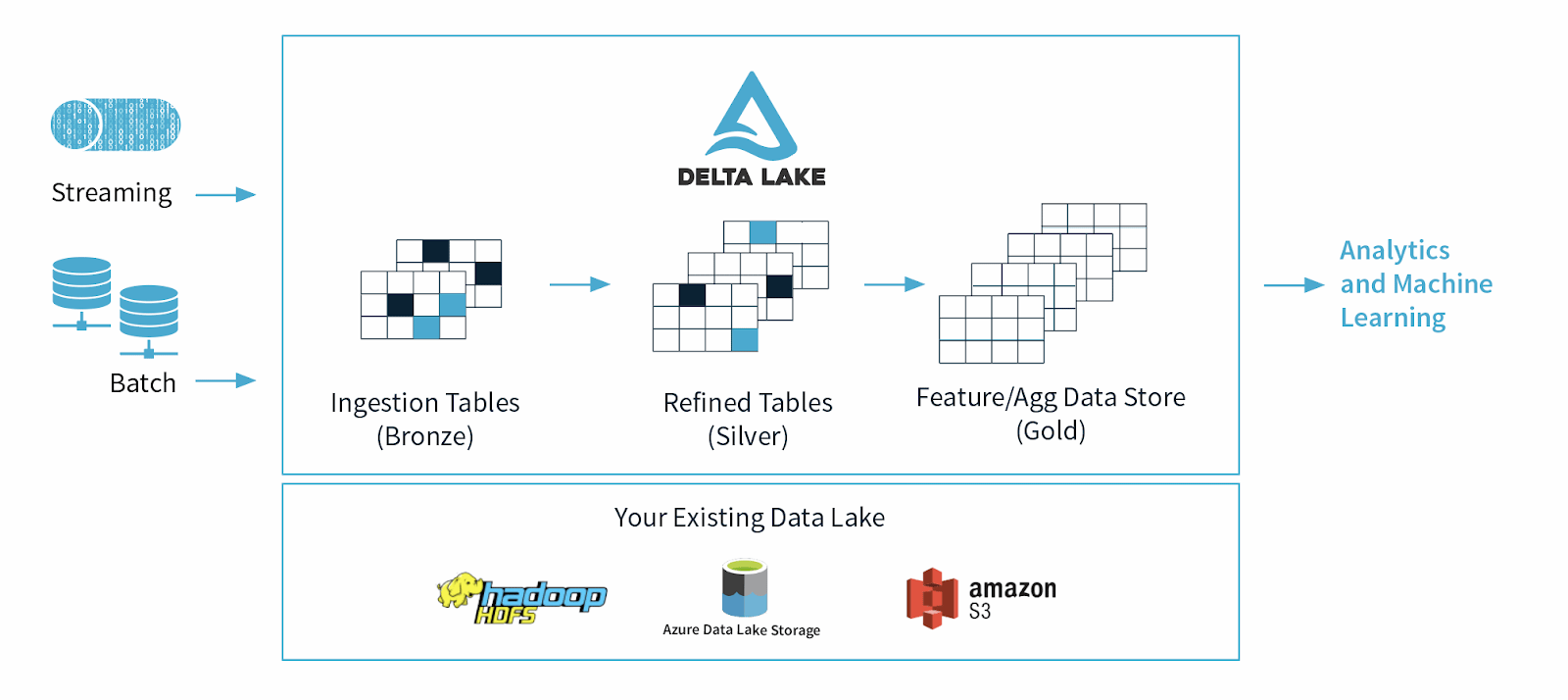

Delta Lake è un framework di data storage open source progettato per ottimizzare l'affidabilità e le performance dei data lake. Risolve alcuni dei problemi più comuni dei data lake, come la coerenza dei dati, la qualità dei dati e la mancanza di transazionalità. Il suo obiettivo è fornire una soluzione di data storage in grado di gestire workload di Big Data scalabili in un'azienda basata sui dati.

Origini dei laghi Delta

Delta Lake è stata lanciata da Databricks, un'azienda Apache Spark, nel 2019 come un formato di tabella cloud basato su standard aperti e parzialmente open source per supportare le funzionalità richieste dalle piattaforme dati moderne, come garanzie ACID, ricritture simultanee, mutabilità dei dati e altro ancora.

Qual è lo scopo o l'uso principale di Delta Lake?

Delta Lake è stato creato per supportare e migliorare l'uso dei data lake, che contengono enormi quantità di dati strutturati e non strutturati.

I data scientist e gli analisti utilizzano i data lake per manipolare ed estrarre preziose informazioni approfondite da questi enormi dataset. Anche se i data lake hanno rivoluzionato il modo in cui gestiamo i dati, presentano anche alcune limitazioni, tra cui la qualità dei dati, la coerenza dei dati e, soprattutto, la mancanza di schemi applicati, che rendono difficile eseguire il machine learning e complesse operazioni di analytics sui dati raw.

Nel 2021, i data scientist del mondo accademico e della tecnologia hanno sostenuto che, a causa di questi limiti, i data lake sarebbero stati presto sostituiti da "lakehouse", che sono piattaforme aperte che unificano il data warehousing e gli analytics avanzati.