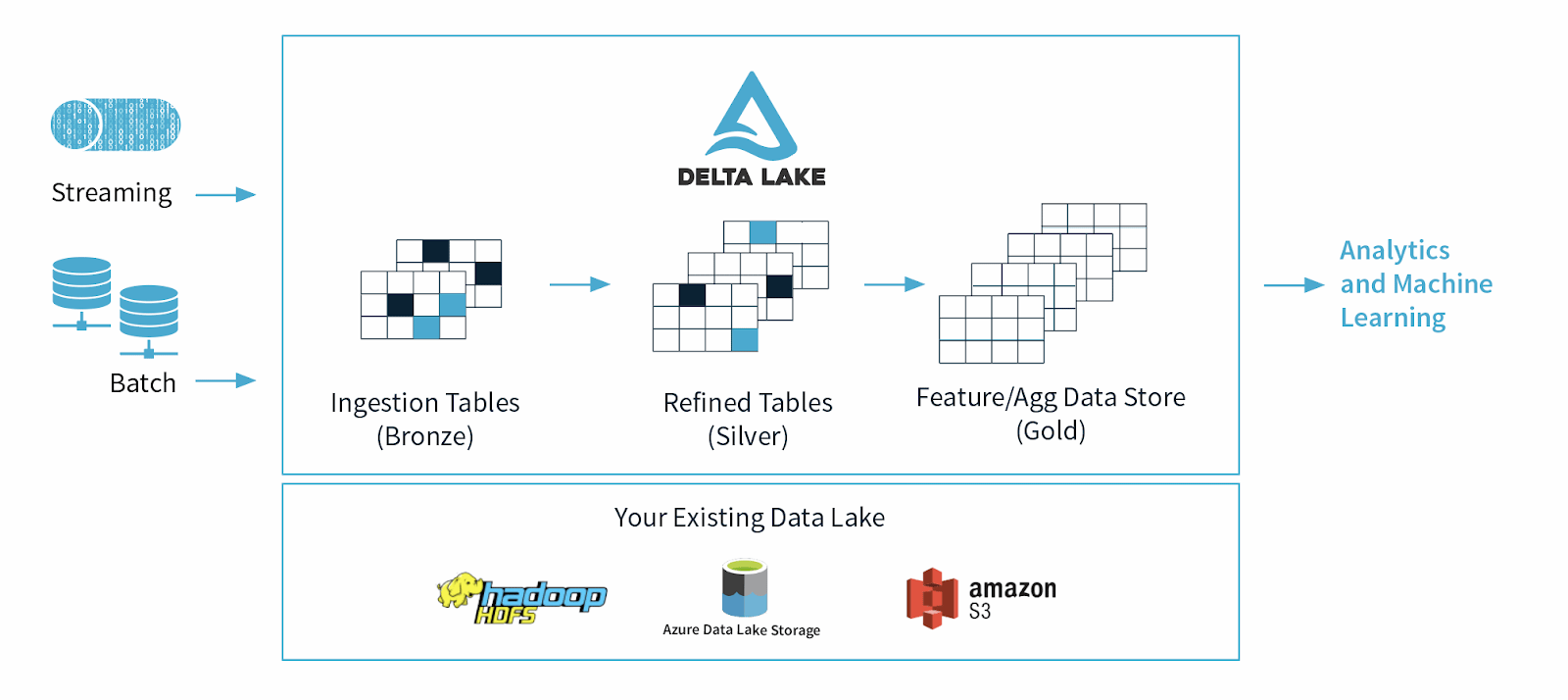

Delta Lake es un marco de almacenamiento de datos de código abierto diseñado para optimizar la fiabilidad y el rendimiento de los lagos de datos. Aborda algunos de los problemas comunes a los que se enfrentan los lagos de datos, como la coherencia de los datos, la calidad de los datos y la falta de transaccionalidad. Su objetivo es proporcionar una solución de almacenamiento de datos que pueda manejar cargas de trabajo de macrodatos escalables en una empresa basada en datos.

Orígenes del lago Delta

Delta Lake fue lanzado por Databricks, una empresa de Apache Spark, en 2019 como un formato de tabla en la nube basado en estándares abiertos y parcialmente en código abierto para soportar las características a menudo solicitadas de las plataformas de datos modernas, como las garantías ACID, los reescritores simultáneos, la mutabilidad de datos y más.

¿Cuál es el propósito o el uso principal de Delta Lake?

Delta Lake se creó para soportar y mejorar el uso de los lagos de datos, que contienen grandes cantidades de datos estructurados y no estructurados.

Los científicos y analistas de datos utilizan lagos de datos para manipular y extraer información valiosa de estos conjuntos de datos masivos. Los lagos de datos han revolucionado el modo en que gestionamos los datos, pero también tienen algunas limitaciones, como la calidad de los datos, la coherencia de los datos y, la principal, la falta de esquemas forzados, lo que dificulta la realización de operaciones de aprendizaje automático y analíticas complejas en los datos brutos.

En 2021, los científicos de datos del ámbito académico y tecnológico argumentaron que, debido a estas limitaciones, los lagos de datos pronto serían sustituidos por “lagos”, que son plataformas abiertas que unifican el almacenamiento de datos y los análisis avanzados.