Directrices para aplicar la normalización

Escalamiento mín-máx: El escalamiento mín-máx es adecuado para algoritmos que requieren que las características de entrada estén dentro de un rango específico, como las redes neuronales y las máquinas vectoriales de soporte. Asegúrese de que los valores atípicos se gestionan adecuadamente, ya que pueden afectar al escalamiento.

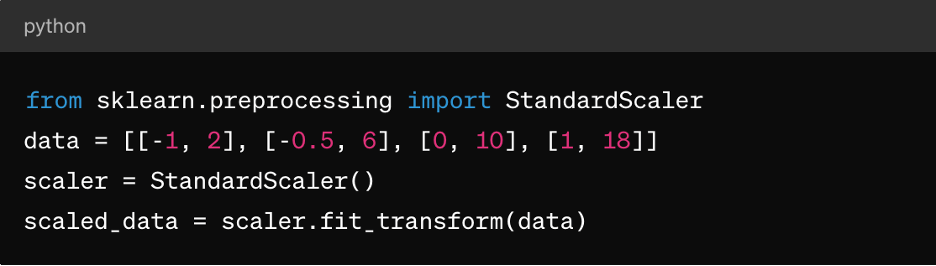

Normalización de la puntuación Z: Esto es adecuado para algoritmos como la agrupación de medios k, la regresión lineal y la regresión logística. El resultado es una distribución centrada en torno a 0 con una desviación estándar de 1, lo que la hace ideal para algoritmos que asumen datos normalmente distribuidos.

Datos dispersos: Para conjuntos de datos dispersos (donde la mayoría de los valores son cero), considere el uso de técnicas como MaxAbsScaler o RobustScaler para la normalización.

Datos categóricos: Para las características categóricas, considere técnicas como la codificación en caliente antes de la normalización para garantizar un escalamiento significativo.

Es importante tener en cuenta que la elección de la técnica de normalización depende de las características específicas de sus datos y de los requisitos del algoritmo de aprendizaje automático que planea usar. La experimentación y la comprensión del impacto sobre el rendimiento del modelo son aspectos clave de la aplicación efectiva de la normalización.

3. Escalamiento de características

El escalamiento de características es una técnica de preprocesamiento de datos que se utiliza para estandarizar el rango de variables o características independientes de un conjunto de datos. El objetivo del escalamiento de características es llevar todas las características a una escala o un rango similares para evitar que una característica predomine sobre otras durante el entrenamiento o el análisis del modelo. El escalamiento de características puede mejorar la velocidad de convergencia de los algoritmos de optimización e impedir que ciertas características tengan una influencia indebida en el modelo.

El papel de la escalabilidad de características en el preprocesamiento de datos

Las funciones de escalamiento garantizan que los algoritmos de ML automático traten todas las características por igual, evitando sesgos hacia las características a mayor escala. También mejora las convergencias, ya que muchos algoritmos de optimización (por ejemplo, el descenso de gradiente) convergen más rápidamente cuando las características se escalan, lo que permite un entrenamiento más rápido del modelo. También puede evitar problemas de inestabilidad numérica que pueden surgir debido a grandes diferencias en las magnitudes de las características. Y, por último, el escalamiento puede facilitar la interpretación del impacto de las características en las predicciones del modelo.

Métodos de escalamiento de características

Además del escalamiento mínimo-máximo descrito anteriormente y la normalización de la puntuación Z, también hay:

MaxAbsScaler: Esto escala cada característica por su valor absoluto máximo, por lo que los valores resultantes van de -1 a 1. Es adecuado para datos dispersos en los que es importante conservar cero entradas, como en sistemas de clasificación de texto o recomendación.

RobustScaler: Esto utiliza estadísticas que son sólidas para los valores atípicos, como la mediana y el rango intercuartil (IQR), para escalar las características. Es adecuado para conjuntos de datos que contienen valores atípicos o distribuciones sesgadas.

Directrices para aplicar el escalamiento de características

Para aplicar el escalamiento de características:

- Aplique la estandarización (normalización de la puntuación Z) cuando los datos sigan una distribución normal o cuando usen algoritmos como la regresión lineal, la regresión logística o la agrupación de medios k.

- Aplique la normalización (escalamiento mín.-máx.) cuando necesite que los datos estén dentro de un rango específico, como las redes neuronales o las máquinas vectoriales de soporte.

- Utilice MaxAbsScaler cuando se enfrente a datos dispersos, como datos de texto o características dispersas de gran dimensión.

- Utilice RobustScaler cuando se enfrente a conjuntos de datos que contengan valores atípicos o características no distribuidas normalmente.

Tenga en cuenta que las características categóricas pueden necesitar codificación (por ejemplo, codificación en caliente) antes de aplicar el escalamiento de características, sobre todo si son nominales (categorías no ordenadas).

4. Gestión de los datos categóricos

Las variables categóricas representan grupos o categorías y a menudo son de naturaleza no numérica, lo que plantea retos durante el entrenamiento del modelo, lo que incluye:

- Representación no numérica: Las variables categóricas suelen representarse usando cadenas o etiquetas, que la mayoría de los algoritmos de aprendizaje automático no pueden procesar directamente. Los algoritmos requieren entradas numéricas para el entrenamiento y las predicciones.

- Variables ordinales frente a nominales: Las variables categóricas pueden ser ordinales (con un orden significativo) o nominales (sin un orden específico). El tratamiento de las variables ordinales como nominales o viceversa puede dar lugar a interpretaciones incorrectas del modelo o a predicciones sesgadas.

- La maldición de la dimensionalidad: La codificación en un solo punto, una técnica común para gestionar los datos categóricos, puede provocar un aumento de la dimensionalidad del conjunto de datos, sobre todo con un gran número de categorías únicas. Esto puede afectar al rendimiento del modelo y aumentar la complejidad computacional.

Técnicas para codificar variables categóricas

Las técnicas para codificar las variables categóricas incluyen:

Codificación de etiquetas: La codificación de etiquetas asigna una etiqueta numérica única a cada categoría de una variable categórica. Es adecuado para variables ordinales en las que hay un orden significativo entre categorías.

Este es un ejemplo de cómo usar el aprendizaje rápido de Python:

desde sklearn.preprocesamiento importación LabelEncoder

le = Codificador de etiquetas()

encoded_labels = le.fit_transform(['cat', 'perro', 'conejo', 'perro'])

Codificación en caliente: Una codificación en caliente crea columnas binarias para cada categoría en una variable categórica, donde cada columna indica la presencia o ausencia de esa categoría. Es adecuado para variables nominales sin un orden específico entre categorías.

Este es un ejemplo de pandas:

importar pandas como pd

df = pd.DataFrame({'category': ['A', 'B', 'C', 'A']})

one_hot_encoded = pd.get_dummies(df['category'], prefijo='category')

Codificación ficticia: La codificación ficticia es similar a la codificación en caliente, pero deja caer una de las columnas binarias para evitar problemas de multicolinealidad en los modelos lineales. Se utiliza comúnmente en modelos de regresión en los que una categoría sirve como categoría de referencia.

Este es un ejemplo de pandas:

dummy_encoded = pd.get_dummies(df['category'], prefijo='category', drop_first=True)

Directrices para el tratamiento de los datos categóricos

Para manejar correctamente los datos categóricos, debe:

Entender los tipos de variables: Determine si las variables categóricas son ordinales o nominales para elegir la técnica de codificación adecuada.

Evite las interpretaciones erróneas ordinales: Tenga cuidado al usar la codificación de etiquetas para las variables nominales, ya que puede introducir una ordinalidad no deseada en los datos.

Aborde la cardinalidad alta: Para las variables categóricas con un gran número de categorías únicas, considere técnicas como la codificación de frecuencia, la codificación de destino o las técnicas de reducción de la dimensionalidad, como la PCA.

Todo esto se suma al tratamiento ya mencionado de los valores que faltan y a la normalización de los datos numéricos.

5. Cómo hacer frente a los datos desequilibrados

Enfrentarse a los datos desequilibrados es un reto común en el aprendizaje automático, sobre todo en las tareas de clasificación, en las que el número de instancias de una clase (clase de menor importancia) es significativamente menor que en las otras clases (clases de mayor importancia). Los datos desequilibrados pueden tener un profundo impacto en el entrenamiento y la evaluación de los modelos, lo que conduce a unos modelos sesgados que favorecen a la clase mayoritaria y que tienen un mal rendimiento en las clases minoritarias.

Estos son algunos puntos clave relacionados con los datos y las técnicas desequilibrados para manejarlos:

Impacto de los datos desequilibrados en el rendimiento del modelo

Los modelos entrenados en datos desequilibrados tienden a priorizar la precisión en la clase mayoritaria y al mismo tiempo descuidan la clase minoritaria. Esto puede dar lugar a un mal rendimiento en las predicciones de clase minoritaria. Además, métricas como la precisión pueden ser engañosas en los conjuntos de datos desequilibrados, ya que una gran precisión puede resultar de predecir correctamente la clase mayoritaria e ignorar la clase minoritaria. Las métricas de evaluación, como la precisión, la F1-score y el área bajo la curva ROC (AUC-ROC), son más informativas para los conjuntos de datos desequilibrados en comparación con la precisión sola.

Técnicas para manejar los datos desequilibrados

Las técnicas más comunes para manejar los datos desequilibrados son la sobremuestreo y la inframuestreo. El sobremuestreo implica aumentar el número de instancias en la clase minoritaria para equilibrarla con la clase mayoritaria. La submuestreo implica reducir el número de instancias en la clase mayoritaria para equilibrarla con la clase minoritaria. También puede adoptar un enfoque híbrido combinando el sobremuestreo y el submuestreo.

También hay ponderación de clase, en la que se ajustan las ponderaciones de clase durante el entrenamiento de modelos para penalizar los errores en la clase minoritaria más que los errores en la clase mayoritaria. Esto solo es útil para algoritmos que admiten ponderación de clase, como regresión logística o máquinas vectoriales de soporte.

Directrices para el tratamiento de los datos desequilibrados

Para manejar los datos desequilibrados, debe:

Entender la distribución de los datos: Analice la distribución de clase en su conjunto de datos para determinar la gravedad del desequilibrio.

Elija la técnica adecuada: Seleccione la técnica de sobremuestreo, submuestreo o híbrida basándose en el tamaño del conjunto de datos, la relación de desequilibrio y los recursos computacionales.

Evalúe las métricas: Utilice métricas de evaluación adecuadas, como precisión, recuerdo, F1-score o curva AUC-ROC, para evaluar el rendimiento del modelo en ambas clases.

Validación cruzada: Aplique técnicas dentro de los pliegues de validación cruzada para evitar la fuga de datos y obtener estimaciones fiables del rendimiento del modelo.

Conclusión

El preprocesamiento de los datos ayuda a garantizar que los modelos de ML automático estén entrenados en datos de alta calidad y con un formato adecuado, lo que afecta directamente al rendimiento, la precisión y la capacidad de generalización del modelo. Al abordar problemas como los valores faltantes, los valores atípicos, las variables categóricas y el desequilibrio de clase, el preprocesamiento de datos permite que los modelos realicen predicciones más informadas y precisas, lo que permite una mejor toma de decisiones en las aplicaciones del mundo real.

Con un preprocesamiento de datos adecuado, los profesionales del ML pueden aprovechar todo el potencial de sus datos y crear modelos predictivos más precisos y fiables para diversas aplicaciones en todos los dominios.

Sin embargo, para lograrlo realmente en el mundo real, primero tiene que tener una solución de almacenamiento de datos flexible, como Pure Storage, que le ayude a acelerar la IA y el aprendizaje automático y a avanzar en sus iniciativas de IA empresarial.